云图娱乐2024年11月16日发布: Meta 公布机器人触觉感知能力研究成果:传感器理解操作外界物体

作者:凯蒂·米克松 | 责任编辑:Admin

本文点赞(53) | 阅读:(66)

【今晚澳门天天有好彩】 |

【2024新奥资料免费精准051】 |

| 【澳门结果记录表888】 |

| 【123澳门六开彩免费资料】 |

| 【澳门一肖一码100精准香港】 |

| 【2024澳门精准正版资料】 |

| 【澳门必中一肖一码100分100】 |

| 【2024澳门全资料免费看】 |

| 【新澳门规律公式】 |

| 【2024年澳门资料天奖开众】 |

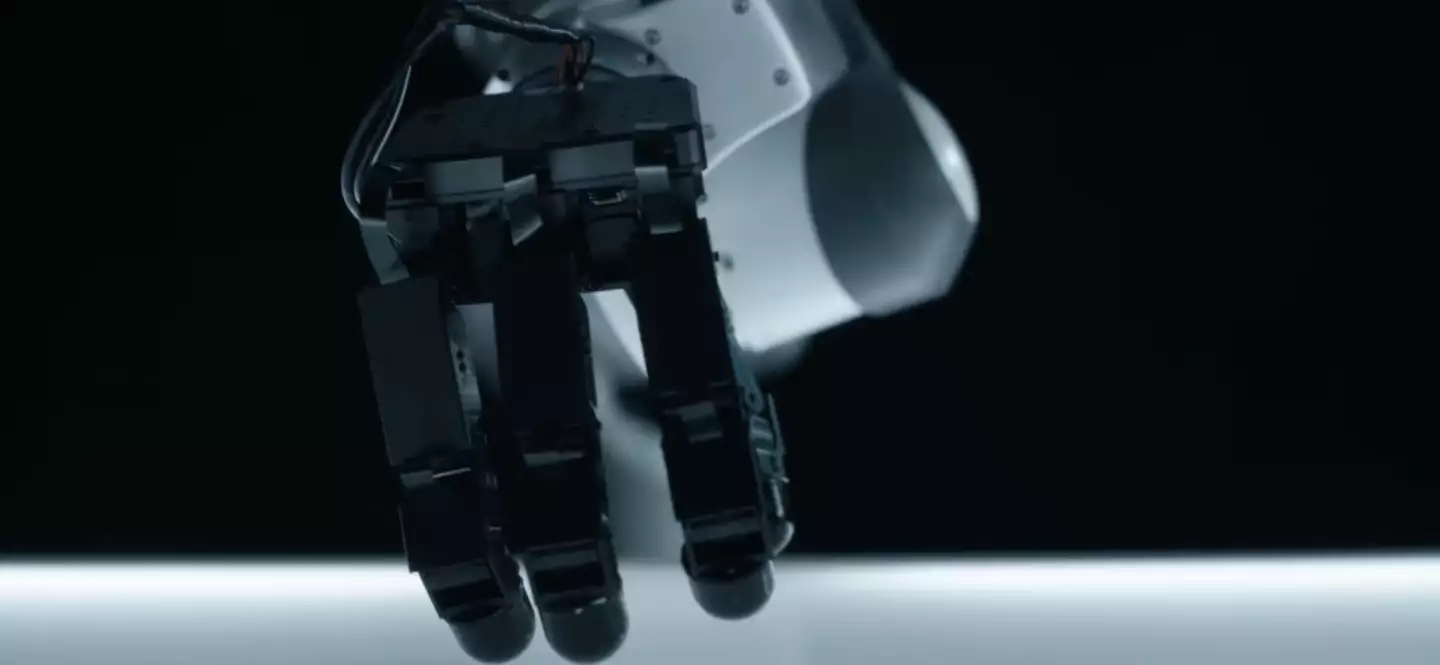

IT之家 11 月 4 日消息,Meta 发布新闻稿,介绍了旗下 FAIR(基础人工智能研究)团队对于机器人触觉感知能力的研究情况,这项研究旨在让机器人通过触觉方式进一步理解和操作外界物体。

Meta 表示,打造相应 AI 机器人的核心在于让机器人的传感器感知理解物理世界,同时利用“AI 大脑”精确控制机器人对物理世界进行反应,而团队目前开发的机器人触觉感知能力主要就是为了让机器人检测其交互的物体的材质与触感,以便于让 AI 判断机器人应当如何操作这些设备(例如拿起鸡蛋等场景)。

IT之家参考 Meta 公布的文献获悉,Meta 目前一共公布了 Meta Sparsh、Digit 360 和 Meta Digit Plexus 等多项研究成果,其中 Meta Sparsh 是一种基于 AI 的触觉编码器,主要利用 AI 的自我监督学习能力实现跨场景的触觉感知,让机器人的 AI 大脑在学习对于某种物体的“触感”后,即可在各种场景灵活“感知”相关物品的特性。

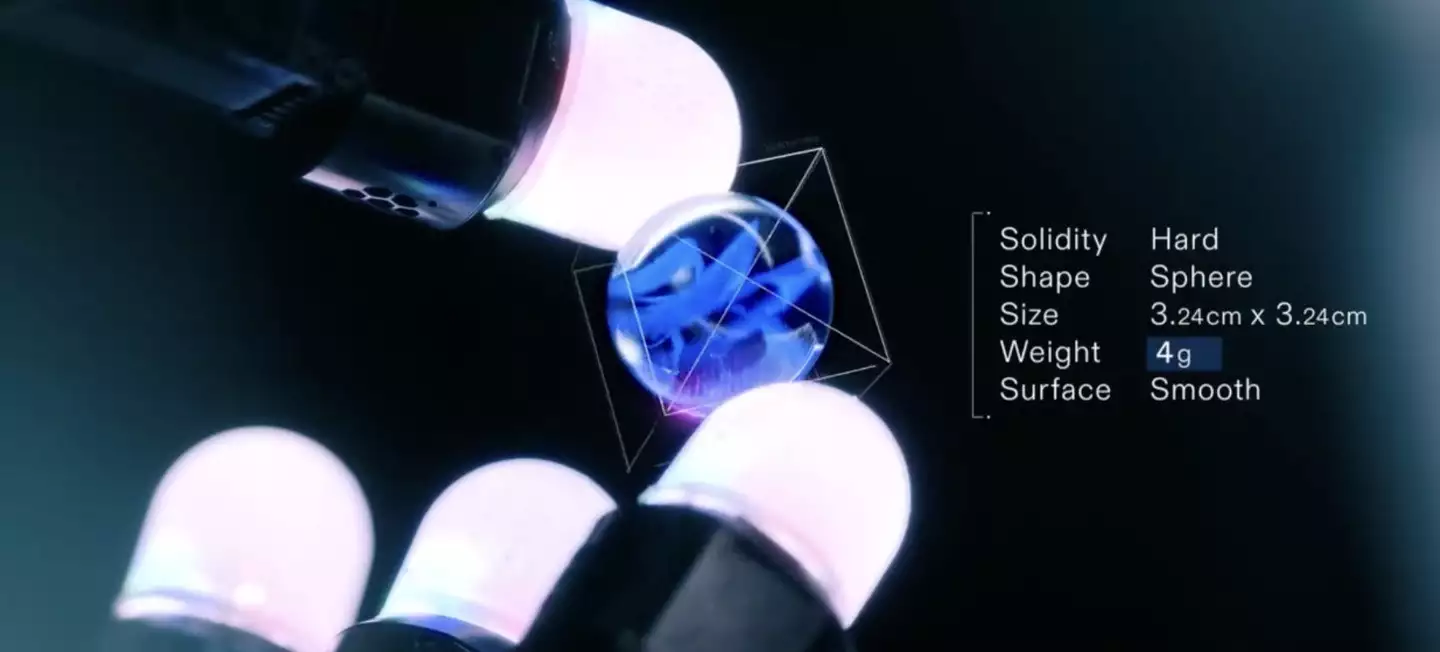

而 Digit 360 则是一种高精度传感器,该传感器主要部署在机器人手指上,号称具备多模态感知能力,能够捕捉细微的触觉变化。Meta 声称,该传感器可以模拟人类的触觉,支持振动、温度等多重感知能力。

Meta Digit Plexus 则是一个开放性的平台,号称能够整合多种传感器,使机器人能够更全面地通过传感器感知周围环境,并通过统一标准实时对接 AI 大脑进行反应。

此外, Meta 还开发了 PARTNR 基准,这是一项用于评估人机协作能力的测试框架,旨在测试机器人 AI 系统在实际生活场景中的计划和推理能力,该测试框架内置 10 万个自然语言任务,能够模拟居家环境中的各种情境,帮助开发者测试机器人对于自然语言的理解能力及执行能力。

Meta 现已对外公开这些技术和数据供研究者使用,包括论文、开源代码和模型等,鼓励更多研究社区参与触觉技术的创新研究,IT之家附相关项目地址如下(点此访问)。

| 【香港最快记录】 | 【72385.cσm查询澳彩】 | 【澳门六开彩天天结果】 | 【澳门最准精选免费资料大全一】 | 【澳门精准资料大全免费经典版更新】 | 【澳门精准免费资料大全华声】 | 【新澳门六号码记录】 | 【天空网资料免费大全】 |

推荐文章

THE9-孔雪儿:坚持热爱,终有回响

4分钟前:Meta 声称,该传感器可以模拟人类的触觉,支持振动、温度等多重感知能力。...

深圳大学国学院院长景海峰:语文学与经学

6分钟前:▲ 图源 Meta (下同)IT之家参考 Meta 公布的文献获悉,Meta 目前一共公布了 Meta Sparsh、Digit 360 和 Meta Digit Plexus 等多项研究成果,其中 Meta Sparsh 是一种基于 AI 的触觉编码器,主要利用 AI 的自我监督学习能力实现跨场景的触觉感知,让机器人的 AI 大脑在学习对于某种物体的“触感”后,即可在各种场景灵活“感知”相关物品的特性。...

滨海有影响的文学社团:雨荷文学社

7分钟前:IT之家 11 月 4 日消息,Meta 发布新闻稿,介绍了旗下 FAIR(基础人工智能研究)团队对于机器人触觉感知能力的研究情况,这项研究旨在让机器人通过触觉方式进一步理解和操作外界物体。...

最新评论

尼古拉·威尔 2024-11-15 24:13

此外, Meta 还开发了 PARTNR 基准,这是一项用于评估人机协作能力的测试框架,旨在测试机器人 AI 系统在实际生活场景中的计划和推理能力,该测试框架内置 10 万个自然语言任务,能够模拟居家环境中的各种情境,帮助开发者测试机器人对于自然语言的理解能力及执行能力。

IP:70.83.2.*

Kai-Yan 2024-11-15 24:15

而 Digit 360 则是一种高精度传感器,该传感器主要部署在机器人手指上,号称具备多模态感知能力,能够捕捉细微的触觉变化。

IP:99.68.4.*

Cinis 2024-11-15 19:17

Meta 现已对外公开这些技术和数据供研究者使用,包括论文、开源代码和模型等,鼓励更多研究社区参与触觉技术的创新研究,IT之家附相关项目地址如下(点此访问)。

IP:64.28.1.*